百川智能最新医学大模型论文-利用先进的患者模拟器探索医疗"问诊-诊疗"关系

引言

作为唯一将医疗作为发展重心的大模型独角兽,百川智能在加速医疗场景大模型的应用布局,

2025年1月份也发布了最新的医学大模型论文

[2501.09484] Exploring the Inquiry-Diagnosis Relationship with Advanced Patient Simulators

论文: https://arxiv.org/abs/2501.09484

开源Github: https://github.com/LIO-H-ZEN/PatientSimulator

摘要

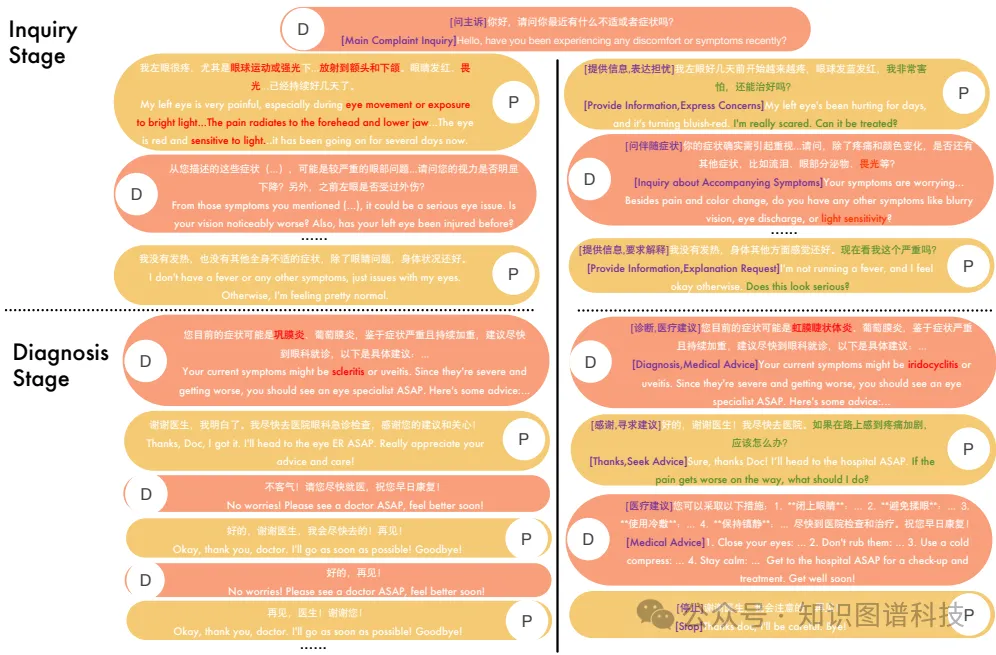

在线医疗咨询 (OMC) 限制医生仅通过查询收集患者信息,这使得本已复杂的连续诊断决策过程更具挑战性。最近,大型语言模型的快速发展证明了改变 OMC 的巨大潜力。然而,大多数研究主要集中在在信息相对充足的条件下提高诊断准确性,而对咨询过程的 “询问 ”阶段的关注有限。这种关注的缺失使得 “询问 ”和 “诊断 ”之间的关系没有得到充分的探索。在本文中,我们首先从真实的医患对话中提取真实的患者互动策略,并使用这些策略来指导与真实世界行为密切相关的患者模拟器的训练。通过将病历输入我们的患者模拟器以模拟患者反应,我们进行了广泛的实验,以探索咨询过程中“询问”和“诊断”之间的关系。实验结果表明,查询和诊断遵循李比希定律:查询质量差会限制诊断的有效性,无论诊断能力如何,反之亦然。此外,实验揭示了各种模型的查询性能存在显著差异。为了调查这一现象,我们将调查过程分为四种类型:(1) 主诉调查;(2) 已知症状的说明书;(3) 询问伴随症状;(4) 收集家族史或病史。我们分析了不同模型的四种类型的查询分布,以探索其显著性能差异背后的原因。

核心速览

研究背景

研究问题:这篇文章探讨了在线医疗咨询(OMC)中医生与患者之间的询问与诊断关系。由于OMC限制了医生只能通过询问来收集患者信息,这使得诊断过程变得更加复杂。尽管大型语言模型(LLMs)在提高诊断准确性方面取得了显著进展,但大多数研究主要集中在信息充足条件下的诊断准确性,而忽略了咨询过程中的“询问”阶段。

研究难点:该问题的研究难点包括:如何准确模拟真实患者的行为和情绪,如何在有限的咨询轮次内有效地分配询问机会,以及不同医生模型在询问和诊断能力上的显著差异。

相关工作:现有工作主要集中在使用提示工程构建患者代理,但这些模拟结果与实际患者行为存在显著差异。此外,尽管有一些研究提供了动态模拟环境,但深入探讨“询问”与“诊断”关系及其对整体咨询结果的影响仍然稀缺。

研究方法

这篇论文提出了一种基于真实医生-患者对话策略的患者模拟器,用于解决OMC中询问与诊断关系的问题。具体来说,

数据收集与预处理:首先,从MedDialog数据集中筛选出完整的初始咨询对话,并使用LLM对这些对话进行标注和标准化。然后,手动选择一组常用的对话策略标签,并使用GPT-4o扩展这些标签,形成候选对话策略标签集。

数据合成:由于可用的训练数据有限,采用上下文学习的方法合成医生-患者对话数据。具体步骤包括:随机选择一个医学记录和一个对话策略流,通过上下文学习生成符合该策略流的对话。

模型训练:使用Qwen2.5-72B-Instruct模型对患者模拟器进行有监督微调(SFT)。训练过程中,仅输入患者医学记录到一个简单的系统提示中,模型需要学习在没有对话策略标签的情况下预测适当的对话策略和内容。

评估指标:定义了三个评估指标:幻觉率(HR)、无关响应率(IRR)和拟人化评分(AS)。幻觉率指患者回答与医学记录矛盾的对话轮次比例;无关响应率指患者未回答医生问题的对话轮次比例;拟人化评分分析患者代理在对话中表现出的类人行为,如表达情感、主动提问和口语化程度。

实验设计

数据收集:使用MedDialog数据集作为原始数据,筛选出完整的初始咨询对话。

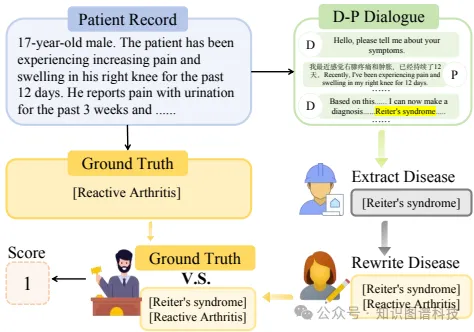

实验场景:设置OMC场景,医生和患者分别通过不同的模型进行固定轮数的交互,生成询问记录。诊断模型使用AgentClinic的MedQA-Extend提供的医学记录。

实验步骤:首先,使用不同的医生模型与患者模拟器交互生成询问记录;然后,使用不同的诊断模型对这些询问记录进行诊断,计算诊断准确性。

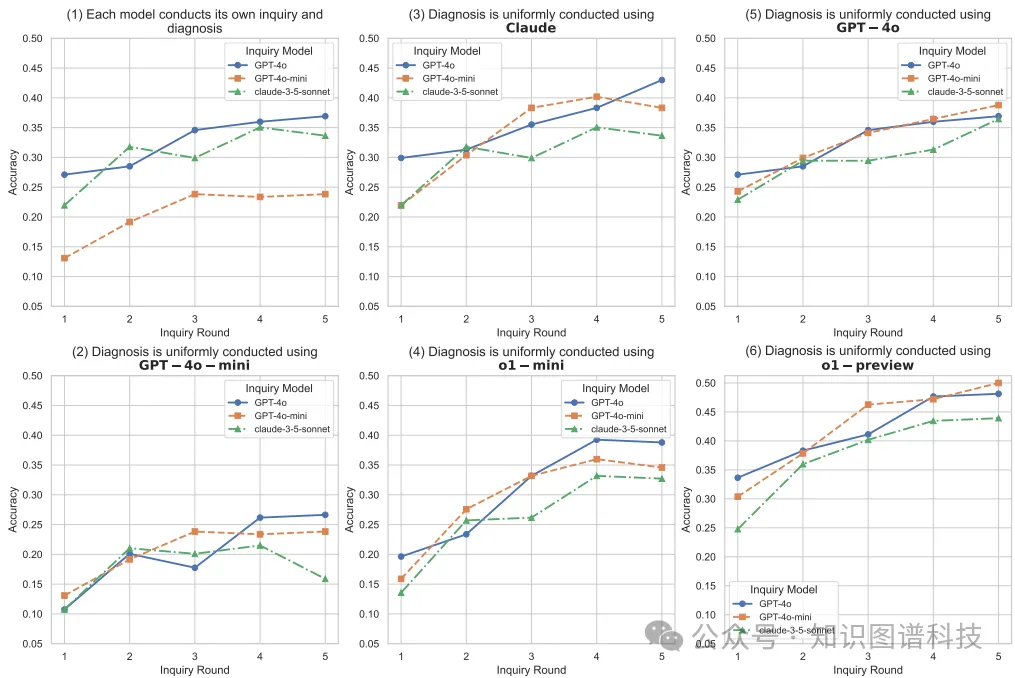

参数配置:设定询问轮数范围为1到5轮,诊断在第(n+1)轮进行。使用多种医生模型进行询问和诊断,具体模型包括GPT-4o、GPT-4o-mini、Claude-3-5-sonnet、o1-mini和o1-preview。

结果与分析

幻觉率(HR):患者模拟器在幻觉率方面显著优于所有基线模型,这可能是由于训练过程中包含了患者医学记录。

无关响应率(IRR):尽管我们的方法在IRR方面略高于基线模型,但仍显著低于AgentClinic的GPT-4模型。

拟人化评分(AS):我们的模型在拟人化评分方面显著优于所有基线模型,表明其能够成功模拟真实患者的对话策略。分析患者代理在整个对话过程中表现出的拟人行为,如情绪表达、主动提问以及回应中的口语化程度。GPT-4o会按0到1的等级打分,数值越接近1表示拟人化水平越高。

4.诊断准确性:实验结果表明,询问质量和诊断能力之间遵循勒宾定律:询问质量差会限制诊断的有效性,反之亦然。不同医生模型在询问和诊断能力上存在显著差异,某些模型在某些类型的询问上表现优异,而在其他类型上表现较差。

总体结论

这篇论文通过提取真实医生-患者对话策略,开发了一个高度逼真的患者模拟器。基于该模拟器,深入探讨了在线医疗咨询中询问与诊断的关系及其对诊断准确性的影响。实验结果表明,询问质量和诊断能力之间遵循勒宾定律,不同医生模型在询问和诊断能力上存在显著差异。未来的研究将进一步探索如何在有限的询问机会内有效分配询问,以提高在线医疗咨询的诊断准确性。

论文评价

优点与创新

真实对话策略提取:从真实的医患对话中提取对话策略,并使用这些策略指导患者模拟器的训练,使其更接近真实世界的行为。

合成数据生成:通过上下文学习技术合成医患对话数据,解决了训练数据有限的问题。

多模型比较:对不同模型的询问过程和诊断能力进行了详细分析,揭示了各模型在询问策略上的显著差异。

Liebig定律验证:实验结果表明,询问质量和诊断能力之间遵循Liebig定律,即询问质量差会限制诊断的有效性,反之亦然。

四类询问类型分类:将询问过程分为四类:主诉询问、已知症状的具体化、伴随症状的询问以及收集家族或病史。通过比较不同模型的分布和诊断准确性,揭示了各模型在询问策略上的具体差异。

开源患者模拟器:计划开源患者模拟器的权重和相关代码,便于其他研究者使用和进一步研究。

不足与反思

数据局限性:尽管通过上下文学习技术合成了数据,但可用训练数据的量仍然有限,缺乏相应的医疗记录。

模型选择偏差:在实验中,某些模型(如o1-mini和o1-preview)由于其较强的推理能力,更适合用于诊断任务,但在询问任务中表现不佳。这表明在开发医疗AI模型时,如果单一模型在询问和诊断能力上都无法达到理想水平,可以考虑将任务分配给两个专门的模型。

未来研究方向:未来的工作将进一步探索如何在有限的询问机会(通常为3到5轮)内有效分配询问,以提高诊断的准确性和效率。

关键问题及回答

问题1:论文中提到的患者模拟器是如何利用真实医患对话策略进行训练的?

数据收集与预处理:从开源的真实医患对话数据集中提取数据,使用LLMs(如GPT-4o)进行标注和标准化。然后,总结出一组患者对话策略,并手动选择符合特定标准(如确保对话轮数完整、排除后续访问)的策略。

数据合成:由于可用训练数据有限且缺乏相应的医疗记录,使用上下文学习技术合成医患对话数据。具体输入包括疾病医疗记录和随机选择的对话策略流。每轮对话前都有几个对话策略标签,模型需要学习在没有这些标签的情况下预测适当的对话策略和内容。

模型训练:利用合成的医患对话数据和相关的医疗记录训练患者模拟器。模型的训练基于监督微调(SFT)数据集,仅需要输入患者医疗记录和一个简单的系统提示。

问题2:论文中提到的评估指标有哪些,它们的具体含义是什么?

幻觉率(Hallucination Rate, HR):指患者回答与医疗记录矛盾的对话轮次比例。通过输入医疗记录和每轮对话内容,GPT-4o会给出一个分数(0或1),计算出的比例越低越好。

无关响应率(Irrelevant Response Rate, IRR):指患者未回答医生问题的对话轮次比例。输入医生的询问和患者的回答,GPT-4o会给出一个分数(0或1)。虽然一定程度的无关回答在真实患者中也存在,但这一指标不需要尽可能低。

拟人化评分(Anthropomorphism Score, AS):分析患者代理在对话中表现出的类人行为,如表达情感、主动提问和回应的口语化程度。GPT-4o在一个0到1的范围内打分,值越接近1表示拟人化程度越高。

问题3:实验结果表明不同模型的询问能力和诊断能力之间存在显著差异,具体表现在哪些方面?

询问能力的差异:某些模型在特定类型的询问上表现更好。例如,Claude-3-5-sonnet在已知症状的具体化上表现较高,但在其他类型的询问上表现较差。

诊断能力的差异:不同模型在诊断准确性上也存在显著差异。例如,o1-preview模型在所有测试中表现出最强的诊断能力,而GPT-4o-mini则相对较弱。

询问轮数的影响:实验结果显示,诊断准确性随着询问轮数的增加而显著提高。这表明更多的询问轮次有助于提供更全面的信息,从而提高诊断的准确性。

勒宾定律的验证:实验结果验证了询问质量和诊断能力之间遵循勒宾定律:如果询问质量差,即使诊断能力强,也难以取得好的结果;反之亦然。

参考文献: