数据编织技术打造智能决策引擎,破局AI 2.0时代数据混沌

AI 2.0时代的智能革命正遭遇数据原力缺失的困境——当万亿级传感器持续轰鸣,当业务决策从月频迈向毫秒级响应,传统数据治理体系已难承载智能跃迁的重任。面对多模态数据洪流吞噬价值、脏数据黑洞侵蚀模型精度、时滞效应割裂业务闭环等系统性挑战,数据编织技术因具备构建实时感知、动态净化与认知融合能力的数据操作系统而备受瞩目。它不仅重新定义了数据供应链的时空边界,更通过构建“数据-模型”双螺旋进化体系,为产业智能化装上实时决策引擎。本文将从四大维度解码数据编制技术如何助力数据生产力的变革。

1、打破数据孤岛:穿透数据洪流的复杂性,激活数据生命力

AI2.0时代的数据生态正面临前所未有的挑战:多模态数据如海啸般涌入,结构化表格、半结构化日志与非结构化图像视频等交织成复杂的语义迷宫,传统数据架构在实时决策与跨域协同需求前动力不足。

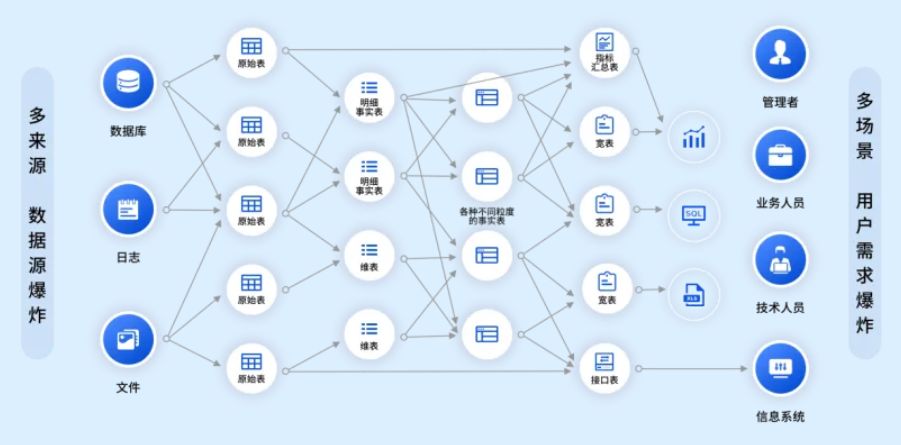

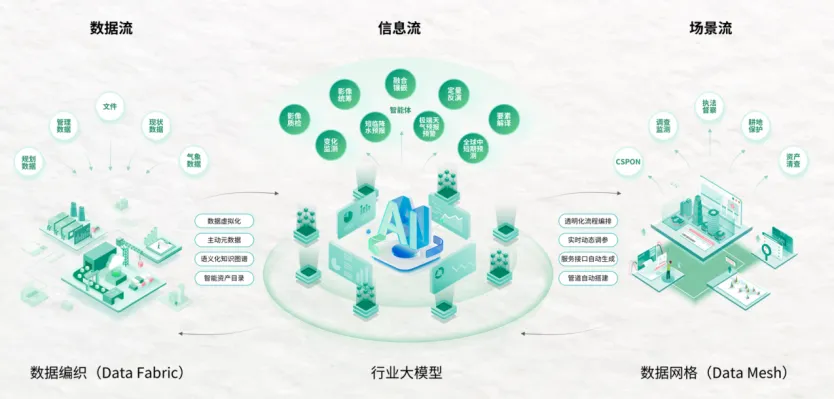

复杂的数据现状 数据编织(Data Fabric)是一种统一的数据架构,可实时连接、集成和管理来自不同来源的数据。它支持跨混合、多云和边缘环境无缝访问数据。数据编织以虚拟化连接技术为矛,穿透云端、边缘与本地系统的数据壁垒,实现文本、时序、图像等异构数据的“无界融合”。利用动态元数据引擎——实时捕获数据血缘、语义标签与上下文关联,将文档、视频等“黑箱数据”转化为可被AI理解的认知单元。 数据编织实现数据连接、集成和管理 2、根治数据顽疾:洞察复杂数据关系,让“脏数据”秒变数据资产 在传统数据源的框架下,数据质量问题严重影响数据分析和应用:结构化数据与非结构化数据混杂堆积、人工标注错漏百出、数据标准模糊不清。 基于数据编织的智能解析引擎,可自动识别数据格式,提取关键实体信息,探查理解非结构化数据中的语义关联;系统中数据清洗基于预置规则与机器学习,动态修正缺失值、剔除重复记录、纠偏异常数据,确保输入模型的每一份数据都“纯净可溯源”;具备动态编目系统,能够自动探查数据血缘,记录数据从采集、流转到训练的完整生命周期,任何数据异常均可秒级定位“污染源”。 数据清洗 3、终结数据时差:从“历史复盘”到“实时连接”,让AI与业务同频共振 在传统数据源的模式下,数据从业务端产生到进入模型训练,往往需要数天甚至数周。数据经导出、清洗、入库后才能更新模型,导致决策错失实时流量转化的黄金窗口。这种数据延迟让用户只能“用过去预测未来”。 数据编织技术则彻底打破这一僵局,构建起“数据-业务-模型”的实时共振网络。实时数据同步:通过虚拟连接,毫秒级抓取业务系统等动态数据,告别传统数据搬运;流式处理引擎:对实时数据流进行即时清洗、关联与特征提取,让模型训练与数据流动“并行推进”,而非被动等待批量数据就绪;动态模型热更新:基于实时数据流自动触发模型微调。基于实时数据流同步与流处理引擎,大模型能够动态捕捉业务变化,将数据更新周期压缩至毫秒级,从而适应众多对时效性要求苛刻的场景。同时,大模型通过自监督学习与合成数据生成,可有效缓解数据稀缺问题。 4、持续数据驱动:数据驱动大模型,大模型反哺数据分析 在人工智能技术高速演进的当下,数据与大模型之间已形成双向赋能的闭环生态。数据作为大模型的“燃料”,通过实时采集、多源整合与智能治理,为模型训练提供高质量、高时效的数据输入。而大模型的输出成果则反哺数据分析体系,形成价值互哺。一方面,模型推理产生的预测结果可直接作为高阶特征,注入数据分析平台,提升业务洞察深度。另一方面,通过强化学习反馈机制,模型能自动识别数据中的异常模式与潜在规律,并将关键发现以智能报告形式反馈给业务系统。 这种“数据-模型共生飞轮”不仅大大降低人工标注成本,更推动数据处理和应用转向主动预测,支持决策范式升级。最终,数据驱动与模型反哺的协同效应,构筑起“感知-决策-优化”的智能闭环,成为企业实现持续数智化提升的核心引擎。 数据与行业大模型双向驱动 结 语 数据编织技术以“无界融合、实时治理、双向赋能”破解AI 2.0时代数据困局。 (1)无界融合:突破传统ETL边界,实现跨模态、跨域数据的认知级整合; (2)实时治理:从离线批处理升级为流式净化,构建“输入即可用”的数据供应链; (3)双向赋能:打通数据与模型的反馈闭环,推动AI系统从“被动响应”转向“主动预测”。 目前,该技术已赋能金融、能源、制造等众多行业,实现企业数据资产利用率大幅提升,决策响应速度进入毫秒时代。