金融级数据库演进范式:微众银行 TiDB 百集群跨代升级全景实录

面对行内超百套TiDB数据库集群因版本碎片化及老旧版本生命周期终止(EOL)所带来的稳定性、安全性与运维成本等多重挑战,微众银行基础科技产品部数据库团队主导并实施了一次核心数据平台系统性升级。本项目已成功将生产、准生产、容灾、测试等全环境共计143套集群中的过半集群,从多个早期版本统一升级至经过金融同业充分验证的 LTS版本。

本文旨在复盘此次升级战况,系统阐述我们在升级规划、技术选型、全链路工程化实施、风险精细化管控以及跨部门协同等方面的完整方法论。我们不仅通过升级解决了迫在眉睫的稳定性与安全问题,更关键的是,沉淀出一套可复用的、金融级的核心数据库大规模持续演进范式。这套范式确保了技术栈的迭代能够平滑、可控地进行,其价值超单次升级本身,能够为行业同类实践提供参考价值的蓝本。

作者:黄蔚

微众银行数据库专家、TiDB社区资深贡献者

/ 第一章:背景与挑战——当“技术债务”转化为明确风险 /

在微众银行,分布式数据库 TiDB 承载着海量金融交易与数据服务的核心使命,其稳定性是业务连续性的基石。然而,随着业务快速发展与技术迭代,一个日益严峻的现实问题逐渐浮现:核心数据库集群的版本体系呈现出高度的碎片化与滞后性。

根据我们详细的资产盘点,在生产环境中,大量核心业务数据库仍运行在已完全停止官方支持或即将临近 EOL 的旧版本,使得绝大多数生产集群潜藏无安全补丁、已知漏洞无法修复的合规与安全风险。

在运维层面,多版本长期并存带来高昂的管理成本。自研的数据库管理平台、监控工具、自动化脚本不得不维护多套适配逻辑,极大消耗研发与运维团队的精力。同时,测试环境与生产环境的版本不一致,也使得测试结果的置信度面临挑战,可能掩盖潜在的兼容性问题。

综上所述,此次升级绝非一次例行的技术迭代,更是我们主动为技术栈建立统一、可持续演进基座的必经之路。

/ 第二章:战略谋划——理性权衡下的技术决策与路径设计 /

面对高复杂、高风险的升级任务,我们进行了周密的技术路径设计,确保每一步都建立在深思熟虑与充分论证之上。

2.1 价值锚点:以稳定与可持续演进为核心的战略选型

在技术选型上,我们面临一个关键抉择:是追求最新的特性,还是选择一个能为未来铺路的稳定基座?经过与业务需求匹配、同业调研与稳定性评估,我们做出了一个以“稳定压倒一切”为核心,并着眼于可持续演进的决策:将全行 TiDB 统一升级至一个经过金融同业充分验证的 LTS 版本。

这一决策基于三大核心考量:

1. 金融级稳定性优先:目标 LTS 版本的代码经过更长时间、更广泛生产场景的淬炼,已知风险极低。这符合金融行业对基础软件“稳定、可靠、可预期”的最高要求,是确保超百集群升级成功的首要前提。

2. 功能完备性满足与方案支撑:该版本已完整包含了我行未来数年业务发展所需的关键特性,如成熟可靠的分区表功能、与 MySQL 8.0 高度对齐的 SQL 生态、强一致的悲观事务模型与 RC 隔离级别、新一代高可用数据同步工具 TiCDC,以及大幅增强的全局内存控制与可观测性体系。其成熟的生态能支撑我们设计差异化升级方案。

3. 构建统一演进基座:此次升级的首要战略目标是彻底终结行内数据库版本的“碎片化”时代。建立一个统一、纯净、易于管理的数据平台基座,这使得未来向任何新版本演进,都将在一个规范化的基础上进行,从“特殊项目”转变为“标准流程”。

2.2 升级原则:分级分批的稳健推进策略

我们确立了严谨的升级原则,确保整个过程风险可控:

业务顺序:内部系统 → 管理后台 → 联机交易 → 批量作业。

集群规模:先小容量集群,再大容量集群。

这套原则确保了我们在升级过程中能够积累经验、控制风险,实现平稳过渡。

2.3 方案博弈:精细化、差异化的升级策略

对于上百套承载不同业务属性、不同重要性等级的集群,我们创新性地设计并实施了“基于业务价值与风险容忍度的三级差异化升级策略”。

三级差异化升级方案包括:

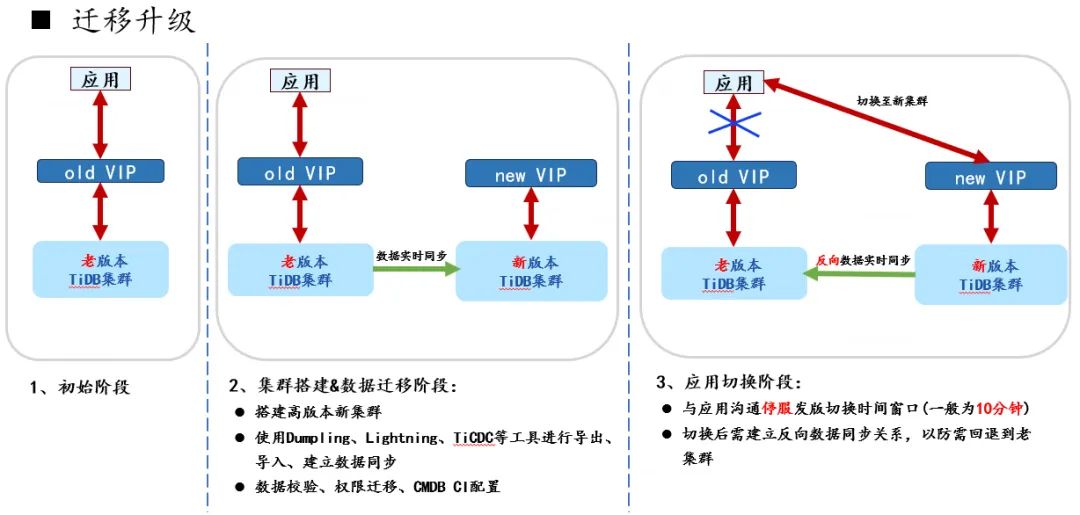

1. 迁移升级(核心业务):建立新的目标版本集群,通过 TiCDC 同步工具从旧集群实时同步数据,切换时实现秒级回退。保障最高安全,但资源成本较高。

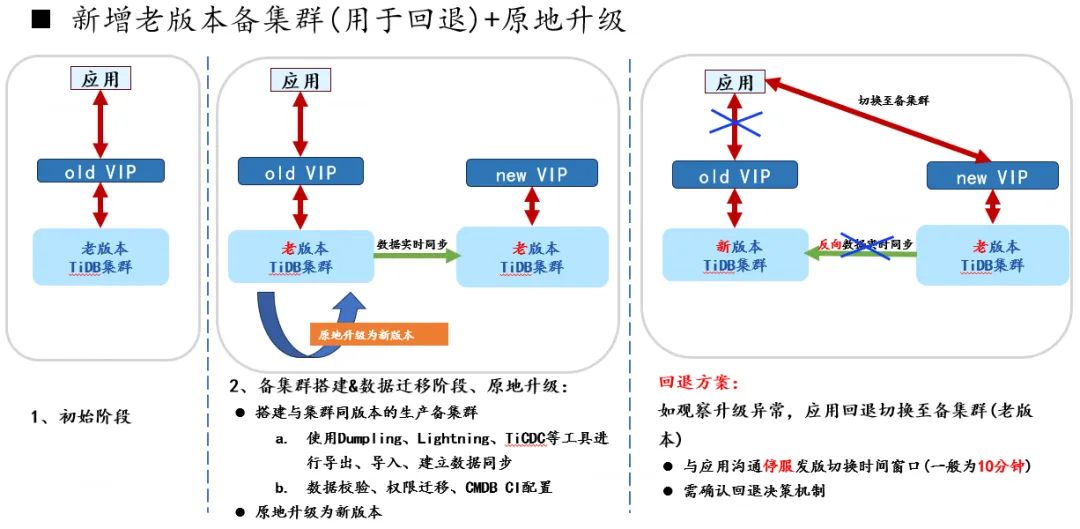

2. 原地+备集群升级(重要业务):主集群原地升级,备集群保持旧版本以备快速回退。平衡了资源投入与风险控制。

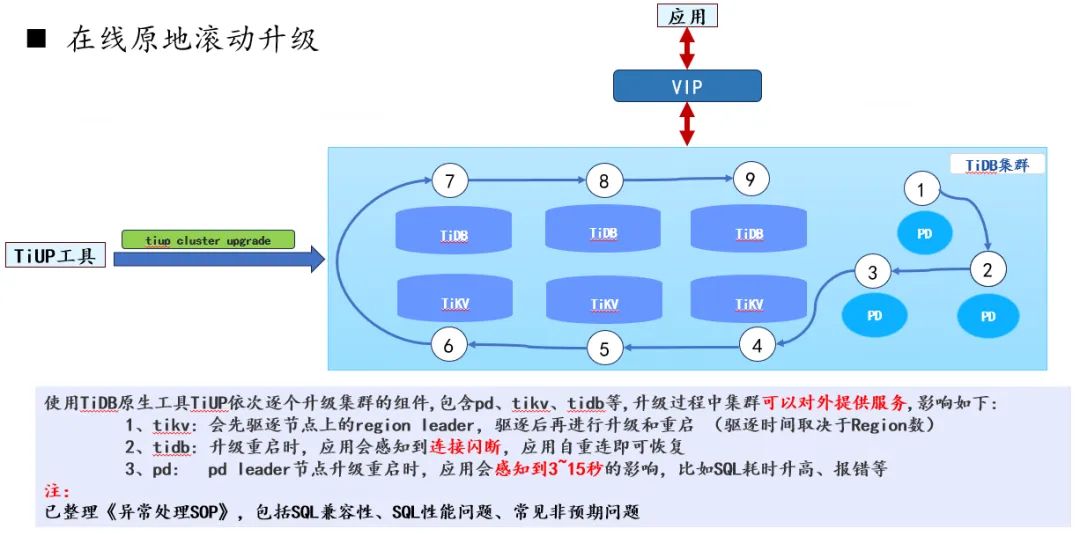

3. 原地滚动升级(一般业务):使用 TiUP 工具进行标准的滚动升级。效率最优,依赖流程控制保障安全。

这一套组合策略,本质上是在“资源成本”、“运维复杂度”与“业务风险”之间进行精密的架构权衡。

/ 第三章:工程化实践——构建全链路、可观测、自动化的防御体系 /

我们将整个升级过程视为一个复杂的系统工程,致力于构建一个工程化体系,覆盖“升级前、升级中、升级后”全链路,且具备深度防御能力。

3.1 核心流程:“测试-生产”配对联动升级模型

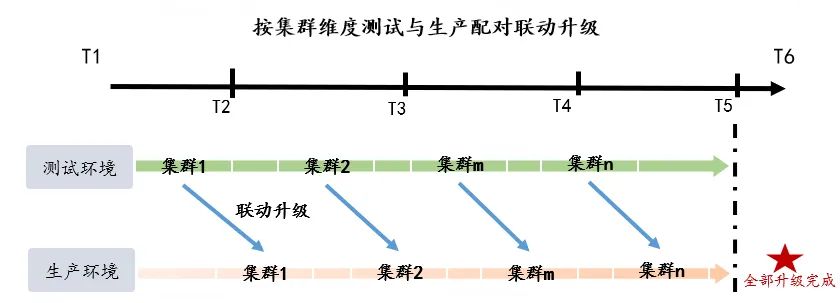

在宏观流程上,我们采用“按集群维度测试与生产配对联动升级”的精益模式:以单个业务线的“测试-生产”环境作为一个最小升级单元。

首先升级测试集群,并立即在该测试环境上完成完整的业务验证;

测试集群验证通过后,立即启动与之配对的生产集群升级。

这套流程最大限度地缩短了测试与生产环境的版本差异周期,是我们在金融级场景下实现“平滑”升级的重要保障。

3.2 升级前:执行计划变更风险前置检测

版本升级后,优化器行为不可避免会发生调整。总体上,大多数 SQL 的执行计划会保持等价甚至得到优化,但仍有少量 SQL 可能出现执行计划劣化,成为升级后性能回退的主要风险之一。

为此,我们与TiDB团队共建并严格执行 Top-N SQL 检查流程,其核心是使用 执行计划变更捕获工具 PCC(Plan Change Capturer),对升级前后执行计划的差异进行系统化识别与评估。

PCC 工具的实现思路如下:

首先,通过脚本从生产集群的 statements_summary_history 等视图中抽取一段时间内对性能影响最大的 Top-N 业务 SQL 样本,连同其执行摘要、表结构与统计信息一起导出(不包含业务数据本身)。

随后,在基准版本(与当前生产一致)和目标版本各搭建一套临时测试集群,重建相关表结构并导入对应统计信息。将上述 SQL 样本记为“驱动 SQL”,由 PCC 工具在两套环境中统一对每条驱动 SQL 执行 EXPLAIN,自动采集执行计划并进行差异比对,从而提前筛查出可能因版本或参数变更导致性能回退的风险 SQL。

我们的标准化工作流程如下:

1)精准数据捕获:

使用定制化的系列脚本,直接基于 TiDB 系统视图(以 statements_summary_history 为主)采集线上真实 SQL 画像,而不是构造随机压测流量。

脚本目前主要支持两类代表性负载的抽取:

Capture STMT TOP 20 SQL:分别按 exec、total_latency_s、avg_latency_ms、total_keys、avg_keys 五个维度各自取 Top 20,随后按 SQL digest 去重,得到一批在“执行次数、总耗时、平均耗时、总扫描量、平均扫描量”多个维度都具代表性的高价值 SQL,并不局限于简单的高频 SQL;

Capture STMT Top EXEC SQL:按照脚本参数中设定的执行频率阈值(例如每小时 ≥ 900 次或 ≥ 1800 次),捕获执行最频繁的一批 SQL,用于覆盖典型高 QPS 负载。

脚本会统一导出这些 SQL 的文本、执行计划摘要、相关表结构与统计信息,为后续计划比对做好准备。

2)慢查询 SQL(4.0 等特定版本):

在 TiDB 4.0 等历史版本中,statements_summary_history 的能力相对早期,对部分典型慢查询的覆盖有限。为补足这类样本,我们在 STMT 类 Top-N 流程之外设计了基于 cluster_slow_query 的 Capture SlowQuery TOP 20 SQL,用于识别耗时最高但未必高频的 SQL,该能力当前仍在逐步落地与完善。

实际使用中,4.0 集群仍以 Capture STMT TOP 20 SQL 和 Capture STMT Top EXEC SQL 为主,SlowQuery TOP 20 作为针对历史版本的增强补充按需启用。

3)隔离环境比对分析:

在隔离环境中分别部署基准版本和目标版本的集群,并加载前述导出的表结构与统计信息。随后由 PCC 工具(通过 PCC STMT TOP 20 SQL 等功能)驱动同一批 SQL,在双环境中统一执行 EXPLAIN,自动采集执行计划并完成差异比对。

PCC 最终生成差异报告,列出所有执行计划发生变化的 SQL 及对应的 plan1/plan2,并对每条计划差异给出简要的 reason(差异原因)。

4)人工研判与 Binding 预案预制:

自动化比对的结果仍需由 DBA 进行专业研判,过滤掉仅由版本差异引入的“非实质”变化,例如执行计划中新增一层 Projection/Limit 包装、列裁剪方式调整,但底层访问路径与算子组合基本保持不变等。

对于最终确认的高风险 SQL,DBA 会预先为每条 SQL 准备标准化的 CREATE BINDING FOR ... USING ... 脚本,沉淀为“执行计划风险知识库”和应急预案库,在正式升级前提前消化可预见的计划风险。

3.3 协同前置:与应用侧共建的兼容性保障体系

数据库作为应用的基础依赖,其版本升级必然对应用生态产生影响。升级之前,将兼容性风险消灭,是确保业务平稳过渡的基石。因此,我们主动发起并协同所有应用研发团队,构建了一套"双向奔赴"的兼容性保障体系。

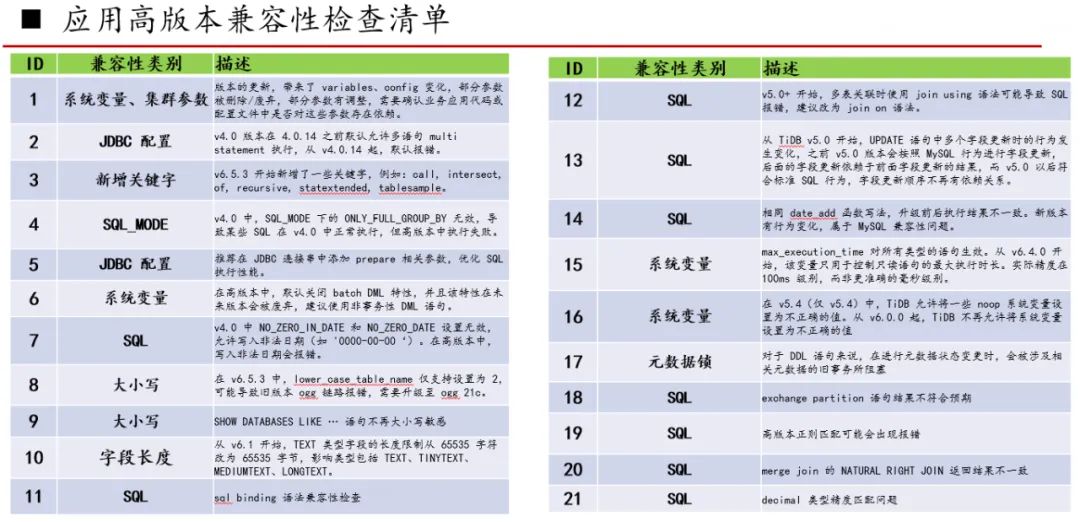

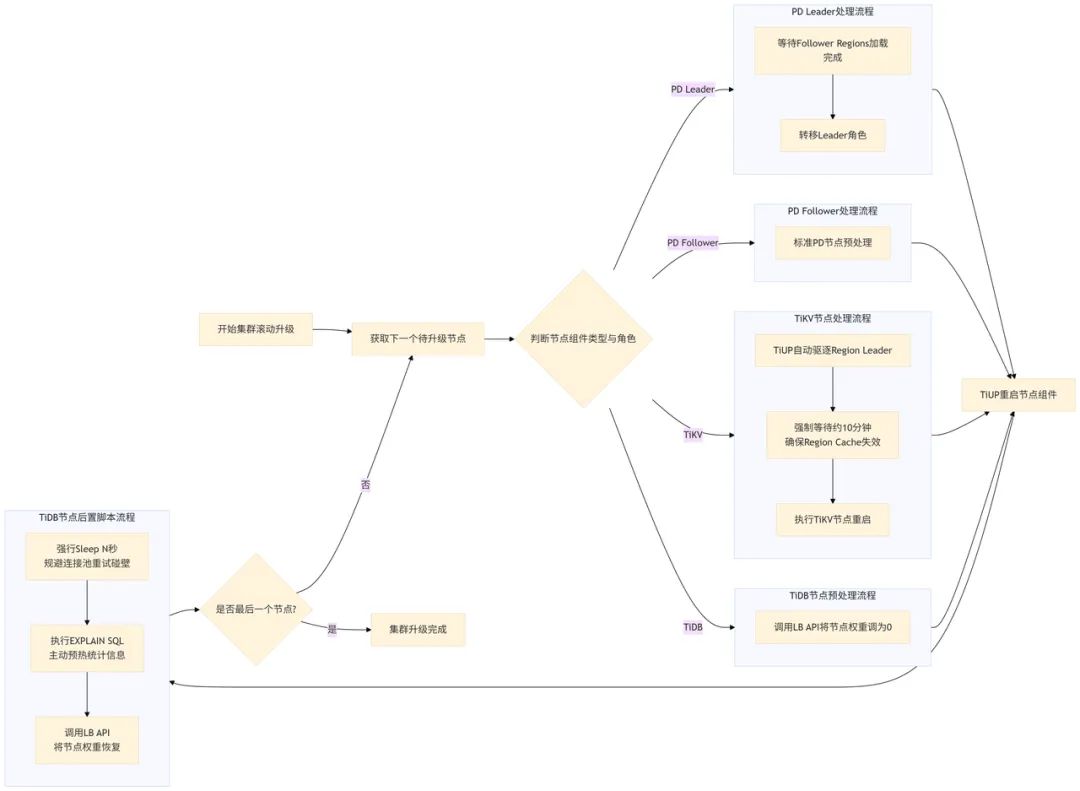

1. 提供清晰的改造指南:我们将散落的、隐性的兼容性知识,系统性地整理为一份覆盖全面的《应用高版本兼容性检查清单》。

该清单明确了从旧版本升级至目标版本时,应用侧需要关注的潜在兼容点,覆盖系统变量与参数、SQL 语法、关键字、JDBC 配置、字段长度限制等关键维度。

这份清单将"未知影响"转化为"可按图索骥的明确任务",为应用提供了统一的检查标准。

2. 主动提供扫描样例与辅助分析:为避免清单流于形式,我们提供扫描样例与辅助分析。例如,针对"TEXT 类型字段长度限制"风险点,我们开发了自动化检测脚本,主动为业务方扫描数据库 Schema,识别出需要将 TEXT 改为 MEDIUMTEXT 的字段。

针对"新增关键字"等需要代码扫描的项,我们提供了扫描样例,帮助开发团队快速定位代码中的潜在风险点。

3. 应用侧响应:基于《应用高版本兼容性检查清单》检查清单,各应用研发团队陆续开展了兼容性改造工作。

其核心流程包括:代码仓库扫描(对 Git 工程代码、XML 中的 SQL 语句进行大规模扫描)、差异分析与评审(针对扫描出的疑似点进行逐一分析)、针对性改造与测试(如调整 SQL 写法、扩展文本字段类型、为 DDL 操作增加重试机制等)。

这套协同体系确保了升级影响面的可知、可控,为升级的平滑推进构筑了坚实防线。

3.3 升级中:增强控制与状态感知

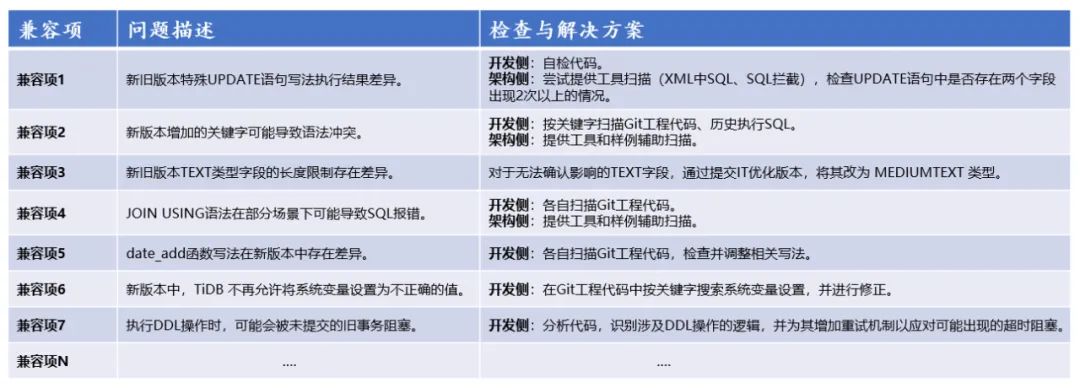

即便使用官方 TiUP 滚动升级工具,在金融级场景下,我们仍认为其默认控制粒度不够精细。为此,我们在不改动 TiUP 源码的前提下,利用 tiup cluster upgrade 提供的 --local-pre-upgrade-script / --local-post-upgrade-script 前/后置脚本接口,使升级流程具备“状态感知”和“流程可编程”能力,实现基于组件类型与角色的差异化预处理与控制,将升级从“黑盒执行”改造为“透明可控”。

该前/后置脚本机制在生产环境中重点用于下文 1(c) 与 2(a) 所述的关键场景,其余扩展能力已在行内完成验证,并将结合业务窗口和风险优先级在后续升级批次中稳步推进。

1、组件差异化预处理:针对不同组件,前置脚本执行截然不同的优雅下线逻辑。

针对 TiDB 节点,执行新流量切断与调度:前置脚本自动调用我行内部负载均衡管理系统的 API,将该 TiDB 节点的服务权重调整至零。此操作的主要目的并非直接断开现有长连接,而是确保负载均衡器将所有新的业务请求调度到其他健康节点,从而为后续该节点的重启和内部准备工作创造一个无新流量干扰的“静默窗口”。

针对 TiKV 节点,增强的 Region Cache 失效等待:TiUP 会自动驱逐 TiKV 节点上的 Region Leader。为确保万无一失,我们的前置脚本在驱逐完成后,会强制等待约 10 分钟。确保所有 TiDB Server 的 Region Cache 完全失效并更新,彻底避免因缓存中的过期路由信息导致请求发往正在重启的 TiKV 节点,从而引发业务超时。

针对 PD 节点(特别是 Leader 角色),执行定制化等待与检查:若节点为 PD Leader,前置脚本会先等待已重启的 Follower 其 Regions 全部加载完成,再触发 Leader 角色转移,以此保证集群元数据管理的万无一失。

2、TiDB 节点统计信息智能预热与连接池保护(核心创新点):针对 TiDB 节点的后置处理,我们引入创新操作以规避性能抖动和潜在风险。

规避连接池误判:节点重启后,在重新接入流量前,后置脚本会首先强行 Sleep N 秒。这一关键停顿旨在人为创造一个时间间隔,有效防止因多个 TiDB Server 节点在负载均衡器上快速轮流重启,导致应用端连接池的重试请求在节点间“连环碰壁”,进而被误判为数据库出现全局性异常。

统计信息智能预热:Sleep 完成后,脚本自动遍历核心业务表的索引,智能生成并执行轻量的 EXPLAIN SELECT ...查询,精准触发统计信息的同步加载。此操作与前置的“权重调零”相配合,确保了节点在统计信息完全就绪后,才会被重新赋予权重并接收新流量,从根本上避免了因统计信息缺失导致的性能断崖式下跌。

3.4 升级后:立体监控与快速止血

升级完成并非终点,而是一个新稳定性周期的开始。我们建立了多层防御的监控与应急体系,确保在出现异常时能快速响应。

1. 全方位指标对比与监控:升级完成后,对比升级前后关键时间窗口的 QPS、P99/P999 延迟、错误率、资源利用率等核心指标,快速发现性能回归或异常波动。

2. 标准化应急工具包快速止血:我们封装了统一的命令行应急工具包。一旦监控告警或业务反馈异常,DBA 可快速通过 SQL 指纹或会话信息定位问题根源,并依据 SOP 指引,选择执行预定义操作(如终止问题会话、查询 MDL 锁状态、实施 SQL Binding 等),实现分钟级快速“止血”。

3. 与前置预案形成闭环:应急流程与升级前的预案预制无缝衔接。对于已识别的风险 SQL,可直接从“执行计划风险知识库”中获取预制的 Binding 脚本并注入;对于新出现的问题,则可利用工具进行即时分析并制定应对策略,形成从风险预防到问题解决的完整闭环。

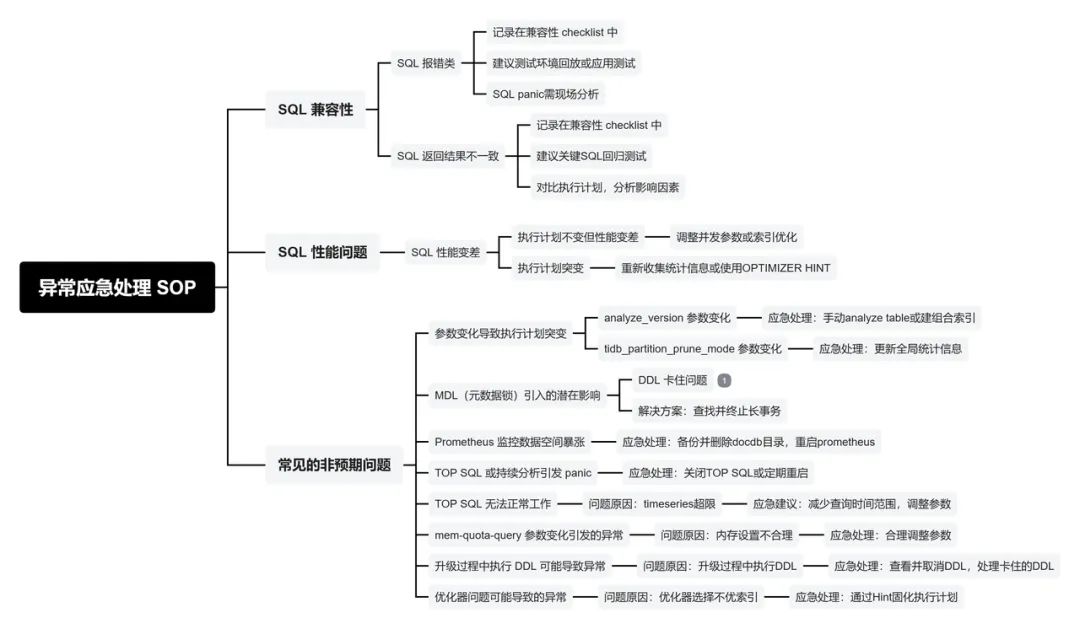

3.5 全景图体系化沉淀:从实战经验到标准化操作程序(SOP)

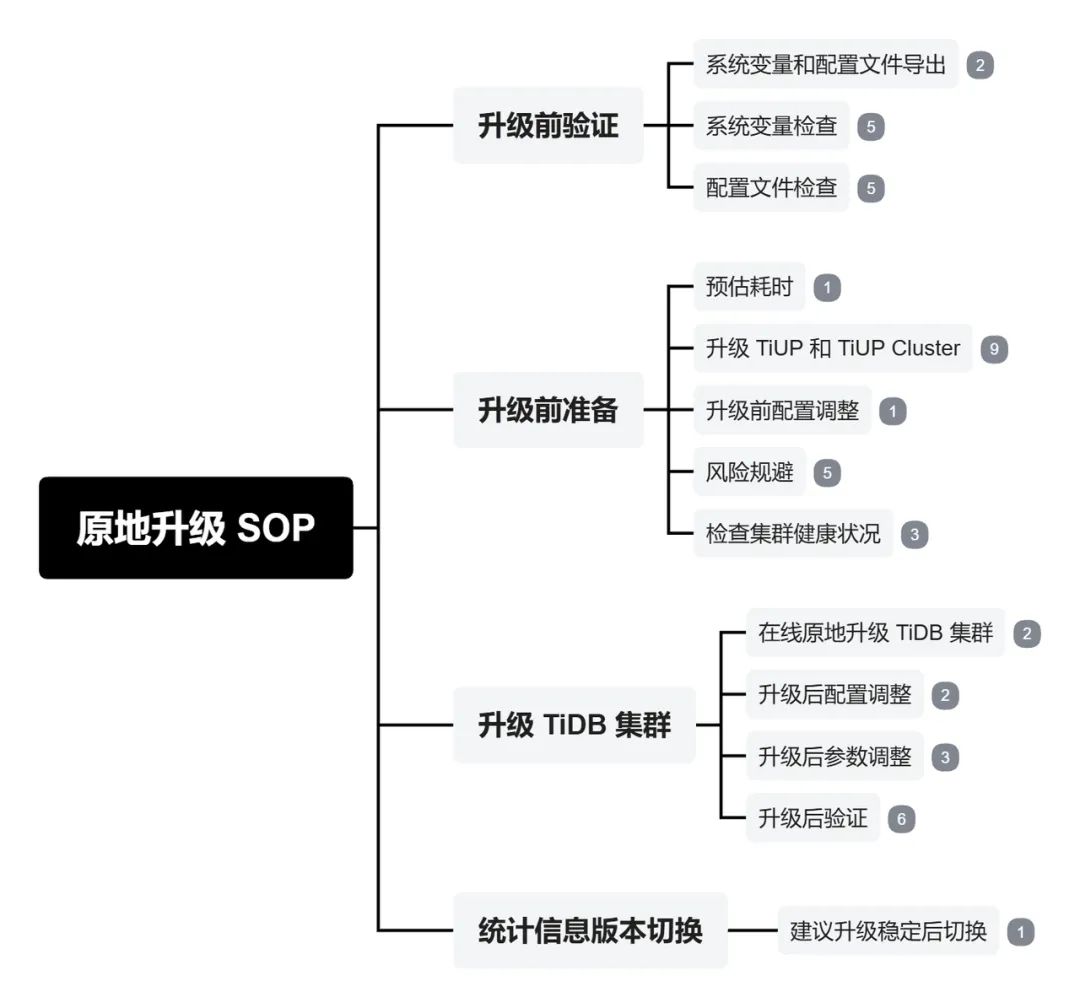

前述章节详细阐述了在升级全链路中各环节的技术实践与创新。为了将这些宝贵的实战经验转化为可重复、可传承的团队资产,我们将其全面沉淀为一套详尽的标准化操作程序(SOP)。

这套 SOP 以思维导图的形式全景式呈现,是指导未来所有同类操作的“作战地图”和检查清单。

1. 异常处理 SOP

2. 原地升级 SOP

3. 迁移升级 SOP

4. 新增备集群+原地升级 SOP

/ 第四章:实战淬炼、风险化解与量化收益 /

再完美的流程也需接受复杂现实环境的检验。在已完成的过半集群升级中,我们遭遇并成功解决了诸多挑战,这些实战让我们的体系更为坚韧,也收获了实实在在的收益。

4.1 典型挑战与体系化应对:从问题清单到深度案例

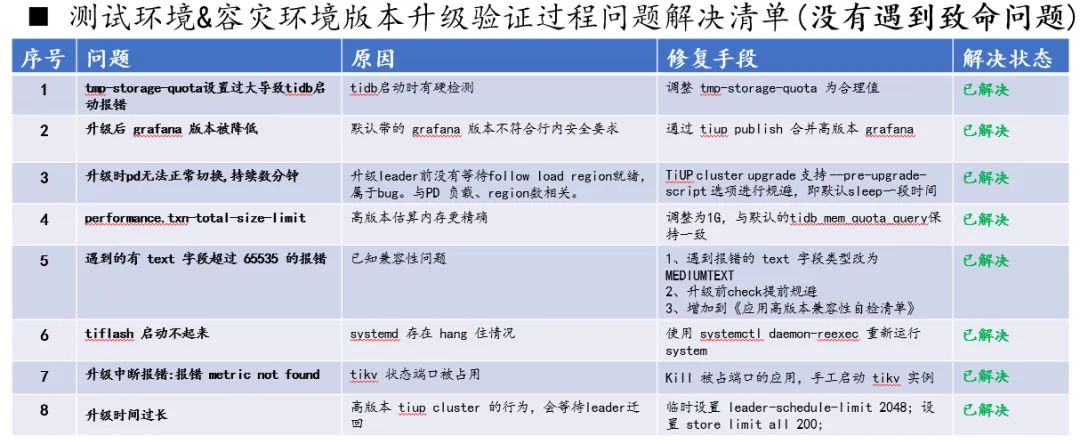

在实战中,我们系统性地记录并解决了升级过程中遇到的各种问题,并形成了可复用的知识库。

下表概述了在测试与容灾环境升级中遇到的部分典型问题及其解决方案:

这份清单是团队共享的知识财富,使得在生产环境执行大规模升级时,能够快速检索预案,从容应对。

深度案例剖析:TiUP 并行传包引发的 PD Leader 异常切换

然而,有些挑战的复杂性和隐蔽性远超清单条目,需要更深入地剖析。下方的典型案例发生在升级某个生产集群时。

问题现象:升级流程在首个 PD Follower 节点即告失败,报错 failed to get pd leader。调查发现,集群的 PD Leader 发生了异常切换,导致元数据服务短暂不可用。

根因深挖:通过对比主机监控与 PD 日志,我们将焦点锁定在磁盘 I/O 压力上。数据显示,PD Leader 节点的磁盘 I/O 利用率在升级启动后瞬间飙升至 100%。根本原因在于:TiUP 工具默认的并行传输机制(SCP)在同时向多个节点分发组件安装包时,对磁盘 I/O 造成了压力,压垮了与 TiKV 共享存储的 PD 服务,进而触发 etcd 的 Leader 切换机制以保障集群可用性。

体系化解决过程:

紧急止血:我们立即启用应急预案,在后续升级中为 tiup cluster upgrade 命令附加 -c 1 参数,强制将并行传包改为串行。此举立竿见影,将 PD Leader 节点的磁盘 I/O 波动最高降至 69%,虽牺牲了约 10-15 分钟的升级时长,但确保了流程继续。

推动根本解决:向TiDB团队提出了产品功能优化需求,提供可配置的传输速率限制参数。这一建议源于金融级场景的严苛要求——必须从工具层面实现更精细的控制,防患于未然。

经验沉淀:此案例深刻揭示,大规模升级的稳定性不仅取决于数据库本身,更依赖于整个工具链和基础设施的协同。我们将 “在升级前评估并预处理基础设施瓶颈” 固化为标准流程,并将与社区共同推动工具链成熟视为一项长期价值。

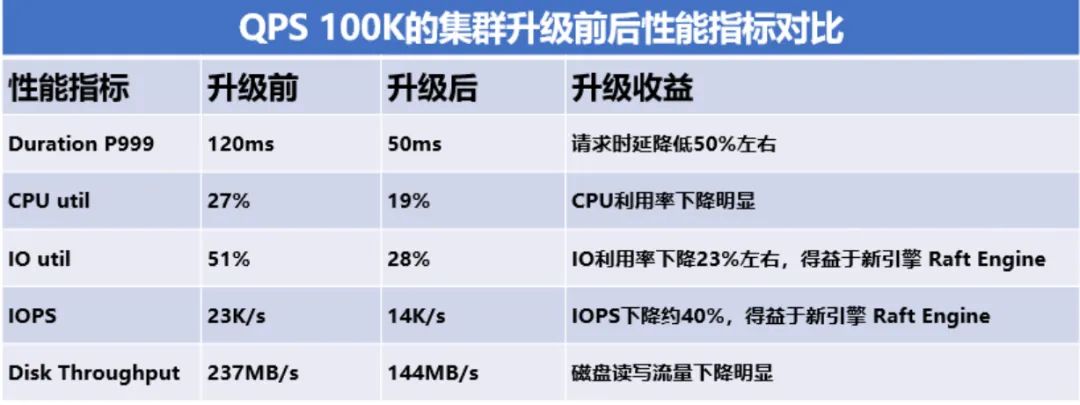

4.2 可量化的核心收益

在已成功升级的集群中,我们观察到以下显著收益。这些收益,既得益于新版本引入的优良特性,也源于升级过程中实施的系统性优化和标准化管理。

1. 性能与资源效率提升:得益于新存储引擎的启用,多个大型写入密集型集群的单实例写入 I/O 负载显著下降,且毛刺减少,更加平稳。在 I/O 密集型负载集群上,观测到 I/O 利用率下降约 20%,IOPS 降低约 50%,在同等业务压力下,获得了显著的资源余量。

2. 运维成本与效率优化:版本统一后,工具链、监控、SOP 全部标准化,团队的日常基础运维效率提升显著。

3. 稳定性与安全性的根本性加固:消除了因旧版本已知 Bug(如特定场景的执行计划突变、内存管理机制不完善)导致的生产事故隐患。所有集群均进入了官方长期支持通道,获得了持续的安全补丁与关键问题修复能力。

4. 新版本特性:成熟可靠的分区表功能、与 MySQL 8.0 高度对齐的 SQL 生态、强一致的悲观事务模型与 RC 隔离级别、新一代高可用数据同步工具 TiCDC,以及大幅增强的全局内存控制与可观测性体系。

/ 第五章:总结、展望与致谢 /

微众银行此次 TiDB 百集群跨代升级项目,不仅可以有效化解因版本碎片化带来的技术债务与运维风险,为未来向更新、更稳定的 LTS 版本平滑演进打下坚实基础。更重要的是,成功构建并验证了一套可持续、可复用的核心数据库持续演进能力。这套能力覆盖了从战略选型、工程化实施到风险管控的全链路,为未来大规模基础设施的迭代奠定了坚实基础。

5.1 半程回顾:沉淀体系化资产

通过本次升级,我们沉淀了三大核心资产,形成了一套可复用的方法论体系:

一套经过实战验证的升级方法论:形成了在金融级场景下,平衡“稳定性、风险与效率”的战略决策与执行框架,包括差异化升级策略、全链路风险防控体系等。

一个高度工程化的工具链与操作体系:将升级流程工具化、标准化,覆盖了从 SQL 深度分析、流量调度到应急响应的关键环节,显著降低了对人为主观经验的依赖。

一支具备深度协同能力的专业团队:跨数据库、业务运维、业务研发、测试等多团队的协作机制得到强化,确保了复杂系统升级过程中各类风险的高效识别与应对。

5.2 未来展望:从项目成功到能力常态化

本次升级的深远意义在于,我们将数据库版本升级从一项高风险、高不确定性的“特殊项目”,转变为一个标准化、可重复、风险可控的“常态化运维能力”。基于此,我们接下来的规划清晰而务实:

1. 完成后半程升级:运用已验证的方法论与工具链,安全、高效地完成剩余集群的升级工作。

2. 推进能力产品化:将本次沉淀的 SOP(标准作业程序)、检查清单和自动化工具,深度集成至行内数据库管理平台,转化为标准的平台功能模块,进一步提升运维效率与规范性。

3. 规划下一代演进:在完成全行版本统一的基础上,并行启动向下一代 LTS 版本的演进评估与概念验证,确保技术栈的迭代始终在可控的轨道上进行。

致谢

本次 TiDB 百集群跨代升级项目得以顺利推进,离不开多方的大力支持,在此我们谨表诚挚的谢忱。感谢行业同仁在项目前期给予的无私经验分享。感谢TiDB官方技术团队在项目关键阶段提供的深入技术支持与紧密协作。特别感谢行内各业务研发、业务运维、测试及基础设施团队在整个过程中的高度协同与卓越贡献,大家的专业、担当与紧密合作是项目成功的基石。我们期待未来能与业界同仁开展更多交流与合作,共同推动分布式数据库技术在金融核心领域的成熟与应用迈向新高度。

本文所探讨的实践经验,基于微众银行基础科技产品部数据库团队主导的 TiDB 大版本升级项目。该项目主要贡献者包括:胡盼盼、黄蔚、刘雪峰、曾敏、张良周。